你能相信AI吗?您是否应毫无疑问地接受其调查结果为客观有效?问题是即使质疑AI本身也不会产生明确的答案。

AI系统通常像黑匣子一样操作:输入数据,输出数据,但转换数据的过程是个谜。这造成了双重问题。一个是不清楚哪种算法的性能最可靠。另一个是看似客观的结果可能会被编程系统的人的价值观和偏见所扭曲。这就是为什么需要透明的系统使用的虚拟思维过程,或“可解释的AI”。

对于受GDPR管辖的任何人来说,道德要求已经成为合法的,这不仅会影响欧盟的企业,也会影响与那里的人或组织打交道的企业。它包含了一些关于数据保护的规定,这些规定扩展到欧盟公民“不受单独自动决策制约的权利,但在某些情况下除外”和“有权获得有关决策所涉逻辑的有意义信息的权利” “。

换句话说,仅仅说“算法拒绝了你的申请”已经不够了。有一个法律授权可以解释导致结论对人们生活产生影响的思路。

有偏见的结果

一些人对算法决策提出的一个担忧是,即使在进行客观推理时,他们也可能会加剧偏见。这就是Cathy O'Neil在“数学毁灭武器:大数据如何增加不平等和威胁民主”中所提出的论点的关键。与大数据相关的客观性外观使其在实际应用中如此有害加强偏见。

她称之为“数学破坏”的是“强化障碍的模型的结果,通过将其视为不太值得信用,教育,工作机会,假释等等来阻止特定人口群体处于不利地位”。

她并不是唯一一个发现算法偏见的人。2016年,Pro Publica分享了他们的研究结果,即算法预测黑人的再犯率高于白人,这一因素在相同类型的犯罪中被转化为不同的监禁。2017年“卫报”文章也将偏见扩展到性别。

问题是这些系统的编程会带来深远的影响。在电话采访中,Collibra的联合创始人兼首席技术官Stijn Christiaens 解释说,AI实现了“自动决策”,每秒可以超过1万个决策。

这意味着制定错误决策的系统将比任何人都更快地制造更多的系统。克里斯蒂安斯说,如果该制度存在偏见,那么大量的决定可能“对某些人群造成损害”,其后果非常严重且普遍存在。

算法的关注与喂养

当然,数据不完整或不良导致错误。这就是一些专家在上面引用的Guardian文章中引用偏倚算法结果的原因。牛津大学的Sandra Wachter总结如下:“世界存在偏见,历史数据存在偏差,因此我们收到偏颇的结果并不奇怪。”

同样,克里斯蒂安斯说,“因为它是基于现实世界的观察,”AI“观察我们的偏见,并产生性别歧视或种族主义的输出。”将他自己的术语应用于俗称垃圾,垃圾输出(GIGO) ),他说问题可能是构成训练数据的 “食物”,因为它本身是错误的,不完整的或有偏见的。

种族主义和性别歧视的结果可以通过不能充分代表人口差异的数据进入系统。他提出了在会议上利用发言人提供培训数据的案例,其中妇女的代表比例可能只有20%。当训练这种倾斜表示时,算法将具有内置偏差。

AI Alchemy

AI偏差问题并不总是由于数据馈送,而在于它的决策方式。这些行动之谜让Ali Rahimi和Ben Recht感到震惊,他们将它与炼金术相提并论。

虽然炼金术可能占有一席之地,但并不是人们想要回答他们关于自动决策的问题的后果。正如Rahimi和Recht所说:“但我们现在正在建立管理医疗保健和参与民事辩论的制度。我想生活在这样一个世界,这个世界的系统是建立在严谨,可靠,可验证的知识上,而不是炼金术。“

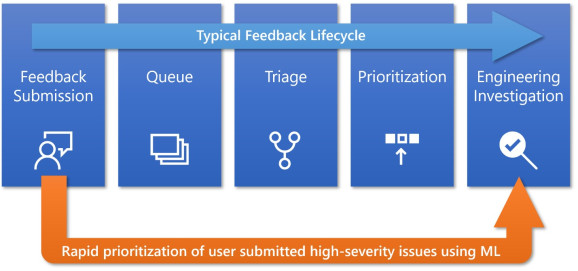

超越黑匣子:发现决定决策的因素

这就是为什么有些人正在寻求一种方法来将透明度引入人工智能系统的思维过程,让它解释为什么它得出了它所做的结论。各地都在努力。

虽然这是朝着正确方向迈出的一步,但解决方案并不完美。因此研究仍在继续,并且根据GDPR,与欧盟相关的人员对实现可解释的人工智能特别感兴趣。

布鲁塞尔大学的人工智能实验室是Christiaens公司成立的机构,也是致力于这种研究的地方之一。他说,实验室已经找到了处理图像识别的方法,并且“网络在语言上解释了已经看到的内容以及为什么”它得出的结论是关于图片中的内容。

“算法总是以同样的方式工作,”Christiaens解释道。“输入数据被转换为特征。”在AI实验室,他们可以“深入了解并查看决策树中发生了什么。”在此基础上,可以“查看所遵循的路径”看看哪里出了问题,然后“调整并重新训练”。

IBM还将其注意力集中在黑匣子问题上,它最近宣布推出一项软件服务,即使在系统运行IBM云的情况下,它也会考虑到AI的决定。除了及时警报外,它还提供了抵消有偏见结果所需数据的建议。

除了云服务之外,IBM还为正在构建机器学习系统的公司提供咨询,以试图在未来减少有偏见的结果。也许其他人工智能专家也会参与咨询,以帮助建立更好的系统,并检查可编程的偏差。

我们必须记住,人工智能系统与设置它们的人类一样容易出错,因此没有人能够对决策进行说明。