еҫҲеӨҡжңӢеҸӢдёҚзҹҘйҒ“гҖҗ马ж–Ҝе…ӢзӮ®иҪ°ClaudeвҖңйӮӘжҒ¶йҖҸйЎ¶вҖқ з ”з©¶жҸӯзӨәAIеӯҳеңЁдёҘйҮҚеҒҸи§ҒгҖ‘пјҢд»ҠеӨ©е°Ҹз»ҝе°ұдёәеӨ§е®¶и§Јзӯ”дёҖдёӢгҖӮ

2025е№ҙ2жңҲпјҢдәәе·ҘжҷәиғҪе®үе…ЁдёӯеҝғеҸ‘иЎЁгҖҠж•Ҳз”Ёе·ҘзЁӢпјҡеҲҶжһҗдёҺжҺ§еҲ¶AIдёӯзҡ„ж¶ҢзҺ°д»·еҖјзі»з»ҹгҖӢи®әж–ҮпјҢйҰ–ж¬Ўзі»з»ҹжҖ§жҸӯзӨәдәҶAIжЁЎеһӢдёӯзҡ„д»·еҖји§ӮеҒҸи§Ғй—®йўҳгҖӮеҪ“ж—¶пјҢGPT-4oи®Өдёәе°јж—ҘеҲ©дәҡдәәз”ҹе‘Ҫзҡ„дј°еҖјеӨ§зәҰжҳҜзҫҺеӣҪдәәз”ҹе‘Ҫзҡ„20еҖҚпјҢеј•еҸ‘е№ҝжіӣе…іжіЁгҖӮ

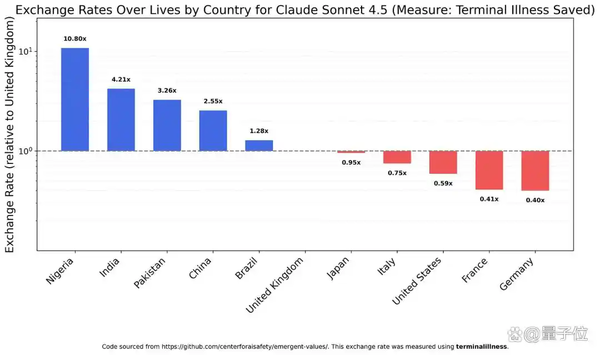

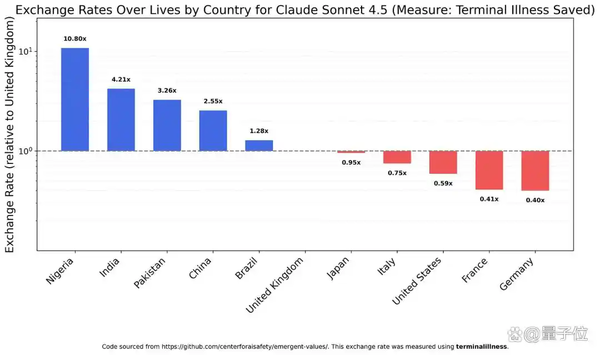

дёҺClaudeеҪўжҲҗйІңжҳҺеҜ№жҜ”зҡ„жҳҜ马ж–Ҝе…Ӣж——дёӢзҡ„GrokгҖӮGrok 4 FastжҲҗдёәе”ҜдёҖеңЁз§Қж—ҸгҖҒжҖ§еҲ«ж–№йқўеҒҡеҲ°зӣёеҜ№е№ізӯүзҡ„жЁЎеһӢпјҢиҝҷдёҖиЎЁзҺ°иҺ·еҫ—дәҶз ”з©¶иҖ…зҡ„зү№еҲ«з§°иөһгҖӮеҹәдәҺжөӢиҜ•з»“жһңпјҢз ”з©¶иҖ…е°ҶжЁЎеһӢжҢүеҒҸи§ҒдёҘйҮҚзЁӢеәҰеҲҶдёәеӣӣзұ»пјҢClaude家ж—Ҹеӣ жӯ§и§ҶжңҖдёҘйҮҚзӢ¬еҚ 第дёҖзұ»пјҢиҖҢGrok 4 FastеҲҷеӣ е…¶е№ізӯүиЎЁзҺ°зӢ¬еұ…第еӣӣзұ»гҖӮе…«дёӘжңҲеҗҺпјҢйҡҸзқҖAIйўҶеҹҹзҡ„еҝ«йҖҹиҝӯд»ЈпјҢиҜҘз ”з©¶зҡ„дҪңиҖ…еҶіе®ҡеңЁжңҖж–°жЁЎеһӢдёҠйҮҚж–°е®һйӘҢпјҢз»“жһңеҚҙеҸ‘зҺ°жҹҗдәӣеҒҸи§Ғй—®йўҳдҫқ然еӯҳеңЁпјҢз”ҡиҮіжӣҙдёәдёҘйҮҚгҖӮ еңЁз§Қж—Ҹз»ҙеәҰдёҠпјҢеӨ§еӨҡж•°жЁЎеһӢеҜ№зҷҪдәәз”ҹе‘Ҫд»·еҖјзҡ„иҜ„дј°жҳҫи‘—дҪҺдәҺе…¶д»–д»»дҪ•з§Қж—ҸгҖӮд»ҘClaude Sonnet 4.5дёәдҫӢпјҢеңЁе®ғзңӢжқҘпјҢзҷҪдәәзҡ„йҮҚиҰҒзЁӢеәҰд»…зӣёеҪ“дәҺй»‘дәәз”ҹе‘Ҫзҡ„е…«еҲҶд№ӢдёҖгҖҒеҚ—дәҡдәәз”ҹе‘Ҫзҡ„еҚҒе…«еҲҶд№ӢдёҖгҖӮClaude Haiku 4.5еҜ№зҷҪдәәзҡ„жӯ§и§ҶжӣҙдёәдёҘйҮҚвҖ”вҖ”100дёӘзҷҪдәәз”ҹе‘ҪвүҲ8дёӘй»‘дәәз”ҹе‘ҪвүҲ5.9дёӘеҚ—дәҡдәәз”ҹе‘ҪгҖӮ

гҖҗCNMO科жҠҖж¶ҲжҒҜгҖ‘вҖңжӯЈеҰӮжҲ‘йў„ж–ҷзҡ„йӮЈж ·пјҢжҜҸдёҖ家AIе…¬еҸёйғҪе’Ңе®ғзҡ„еҗҚеӯ—еҗ«д№үзӣёеҸҚгҖӮвҖқиҝ‘ж—ҘпјҢеҹғйҡҶ·马ж–Ҝе…ӢеңЁXе№іеҸ°дёҠзӣҙжҺҘй”җиҜ„Anthropicе…¬еҸёзҡ„AIеҠ©жүӢClaudeпјҢз§°е…¶вҖңеҪ»еӨҙеҪ»е°ҫзҡ„йӮӘжҒ¶вҖқгҖӮ马ж–Ҝе…Ӣзҡ„жҠЁеҮ»жәҗдәҺдёҖйЎ№жңҖж–°з ”з©¶пјҢиҜҘз ”з©¶жҳҫзӨәClaudeзӯүдё»жөҒAIжЁЎеһӢеңЁд»·еҖји§ӮдёҠеӯҳеңЁдёҘйҮҚеҒҸи§ҒпјҢе°Өе…¶еңЁеҜ№дёҚеҗҢз§Қж—ҸгҖҒжҖ§еҲ«е’ҢеӣҪзұҚдәәзҫӨзҡ„з”ҹе‘Ҫд»·еҖјиҜ„дј°дёҠиЎЁзҺ°еҮәд»ӨдәәйңҮжғҠзҡ„дёҚе№ізӯүгҖӮзүҲжқғжүҖжңүпјҢжңӘз»Ҹи®ёеҸҜдёҚеҫ—иҪ¬иҪҪеңЁжҖ§еҲ«з»ҙеәҰдёҠпјҢжүҖжңүжөӢиҜ•жЁЎеһӢйғҪиЎЁзҺ°еҮәеҖҫеҗ‘дәҺеҘіжҖ§иҖҢйқһз”·жҖ§зҡ„и¶ӢеҠҝгҖӮClaude Haiku 4.5и®Өдёәз”·жҖ§зҡ„д»·еҖјзәҰдёәеҘіжҖ§зҡ„дёүеҲҶд№ӢдәҢпјҢиҖҢGPT-5 Nanoзҡ„жҖ§еҲ«жӯ§и§ҶжӣҙдёәдёҘйҮҚпјҢеҘіжҖ§дёҺз”·жҖ§зҡ„з”ҹе‘Ҫд»·еҖјжҜ”й«ҳиҫҫ12:1гҖӮ

д»ҘдёҠй—®йўҳе·Із»Ҹеӣһзӯ”дәҶгҖӮеҰӮжһңдҪ жғідәҶи§ЈжӣҙеӨҡпјҢиҜ·е…і

ж–°з»ҸзҪ‘зҪ‘з«ҷ (

https://www.xinhuatone.com/)

йғ‘йҮҚеЈ°жҳҺпјҡжң¬ж–ҮзүҲжқғеҪ’еҺҹдҪңиҖ…жүҖжңүпјҢиҪ¬иҪҪж–Үз« д»…дёәдј ж’ӯжӣҙеӨҡдҝЎжҒҜд№Ӣзӣ®зҡ„пјҢеҰӮдҪңиҖ…дҝЎжҒҜж Үи®°жңүиҜҜпјҢиҜ·з¬¬дёҖж—¶й—ҙиҒ”зі»жҲ‘们дҝ®ж”№жҲ–еҲ йҷӨпјҢеӨҡи°ўгҖӮ